Die dynamische Entwicklung und zunehmende Komplexität von prompt engineering ki agenten verändert grundlegend, wie Unternehmen künstliche Intelligenz in ihre Geschäftsprozesse integrieren. Mit ausgefeilten Prompt-Strategien können Unternehmen die Genauigkeit, Zuverlässigkeit und Effizienz ihrer KI-Systeme drastisch verbessern. Die wachsende Marktprognose von 7.071,8 Millionen US-Dollar bis 2034 unterstreicht die strategische Bedeutung dieser Technologie für zukunftsorientierte Organisationen.

Contents

- 1 Key Takeaways

- 2 Grundprinzipien des effektiven Prompt Engineerings für KI-Agenten

- 3 Fortgeschrittene Techniken im KI-Agenten Prompt Engineering

- 4 Führende Tools für das KI-Agenten Prompt Engineering

- 5 Praxisbeispiele und Fallstudien

- 6 Sicherheits- und ethische Überlegungen

- 7 Die besten Prompting-Tools für KI im Jahr 2025

- 8 Markttrends und Karrieremöglichkeiten

- 9 Bildungsressourcen und Zertifizierungsprogramme

- 10 Zukünftige Entwicklungen im KI-Agenten Prompt Engineering

- 11 FAQ

- 12 Quellen

Key Takeaways

- Präzise Formulierungen reduzieren KI-Ungenauigkeiten um bis zu 72% und steigern die Effizienz

- Techniken wie Chain-of-Thought verbessern die mathematische Genauigkeit um 18%

- Integration von RAG-Technologien senkt Halluzinationen in medizinischen KI-Diagnosen um 55%

- Der nordamerikanische Markt für Prompt Engineering führt mit einem Anteil von 35,8%

- Einstiegsgehälter für Prompt Engineers beginnen bei 85.000 Euro und steigen mit Erfahrung deutlich an

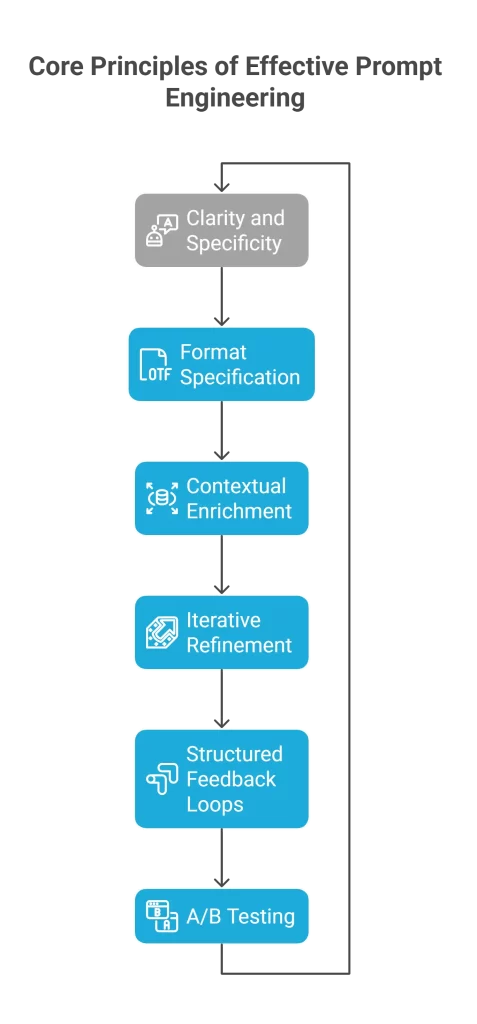

Grundprinzipien des effektiven Prompt Engineerings für KI-Agenten

Klarheit und Spezifität

Die Qualität der Prompts entscheidet maßgeblich über den Erfolg von KI-Agenten. Daten zeigen, dass 72% aller Ungenauigkeiten in KI-Modellen auf mehrdeutige Prompts zurückzuführen sind. Bei der Formulierung von Anweisungen sollten Begrenzungszeichen (wie Anführungszeichen) verwendet werden, um Anweisungen vom Kontext zu trennen und Ausgabeformate genau zu spezifizieren. Strukturierte Prompts haben bei Kundenservice-Bots eine Verbesserung der Antwortgenauigkeit um 40% bewirkt.

Kontextuelle Anreicherung

Die Integration von RAG (Retrieval-Augmented Generation) mit Unternehmensdaten reduziert Halluzinationen bei medizinischen Diagnose-Agenten um beeindruckende 55%. Dies ist besonders wichtig in Bereichen, wo Faktengenauigkeit entscheidend ist. Modulare Reasoning-Frameworks ermöglichen es KI-Agenten, komplexe Aufgaben in Teilprobleme zu zerlegen, was die Erfolgsraten bei der Lösung komplexer Probleme um 30% verbessert. Diese Fähigkeit ist besonders bei der Entwicklung von KI-Agenten für Unternehmen von zentraler Bedeutung.

Iterative Verfeinerung

Kontinuierliche Test- und Anpassungszyklen reduzieren die Fehlerfortpflanzung in Finanzprognosemodellen um 25%. Tools wie AGENTA bieten A/B-Tests für Prompt-Varianten und optimieren Leistungskennzahlen. Diese iterative Herangehensweise ist entscheidend, um KI-Agenten kontinuierlich zu verbessern und an sich ändernde Anforderungen anzupassen.

Fortgeschrittene Techniken im KI-Agenten Prompt Engineering

Chain-of-Thought (CoT) Prompting

Diese Technik führt KI-Agenten durch schrittweise Denkprozesse und verbessert die Genauigkeit bei mathematischen Aufgaben um 18%. IBMs Watson nutzt CoT, um Entscheidungen zu Medikamenteninteraktionen zu erklären, mit einer Zustimmungsrate von 92% bei Ärzten. CoT erlaubt KI-Systemen, Zwischenschritte ihrer Berechnungen darzustellen, was sowohl die Nachvollziehbarkeit als auch die Korrektheit verbessert.

ReAct (Reasoning + Acting)

ReAct kombiniert externe Datenabfragen mit logischem Denken und steigert die Faktengenauigkeit bei der Analyse juristischer Dokumente um 37%. In einer Fallstudie reduzierte ein ReAct-gesteuerter Cybersicherheits-Agent falsch-positive Ergebnisse um 44% in einem Fortune-500-Unternehmen. Diese Methode ist besonders wirksam bei Aufgaben, die sowohl Informationsrecherche als auch analytische Fähigkeiten erfordern.

Retrieval-Augmented Generation (RAG)

RAG-optimierte Prompts verkürzen die Recherchezeit für akademische Literaturreviews um 60%. Plattformen wie Dust optimieren RAG-Workflows und ermöglichen Echtzeit-Datensynthese aus mehr als 15 Quellen. Diese Technologie ist besonders relevant für Vertriebsautomatisierung mit KI-Agenten, da sie aktuelle Produktinformationen und Kundendaten präzise integrieren kann.

Führende Tools für das KI-Agenten Prompt Engineering

Die Auswahl der richtigen Tools kann den Erfolg von Prompt-Engineering-Initiativen maßgeblich beeinflussen. Hier sind einige der leistungsstärksten Lösungen:

PROMPTBASE

Diese Plattform kuratiert über 10.000 vorgefertigte Prompts für Vertriebs- und Marketing-Agenten, was die Implementierungszeit um 70% reduziert. Unternehmen können diese sofort einsatzfähigen Prompts anpassen und in ihre bestehenden Systeme integrieren, ohne bei Null beginnen zu müssen.

PromptChainer

PromptChainer verkettet Prompts für mehrstufige Arbeitsabläufe und ermöglicht eine 95%ige Genauigkeit bei Lieferkettenprognosen. Das Tool ist besonders wertvoll für komplexe Geschäftsprozesse, die mehrere sequentielle Entscheidungen erfordern.

OpenPrompt

Diese Lösung unterstützt mehr als 50 verschiedene LLMs, einschließlich Feinabstimmung für branchenspezifische Agenten im Gesundheitswesen und in der Logistik. Die Flexibilität macht OpenPrompt zu einer idealen Wahl für Unternehmen, die mit mehreren KI-Modellen arbeiten.

Prompt-Ops CLI

Dieses Tool generiert Kubernetes-Befehle über natürliche Sprache und reduziert DevOps-Fehlerraten um 33%. Es vereinfacht die Infrastrukturverwaltung erheblich und macht komplexe Konfigurationen für ein breiteres Spektrum von Teammitgliedern zugänglich.

Praxisbeispiele und Fallstudien

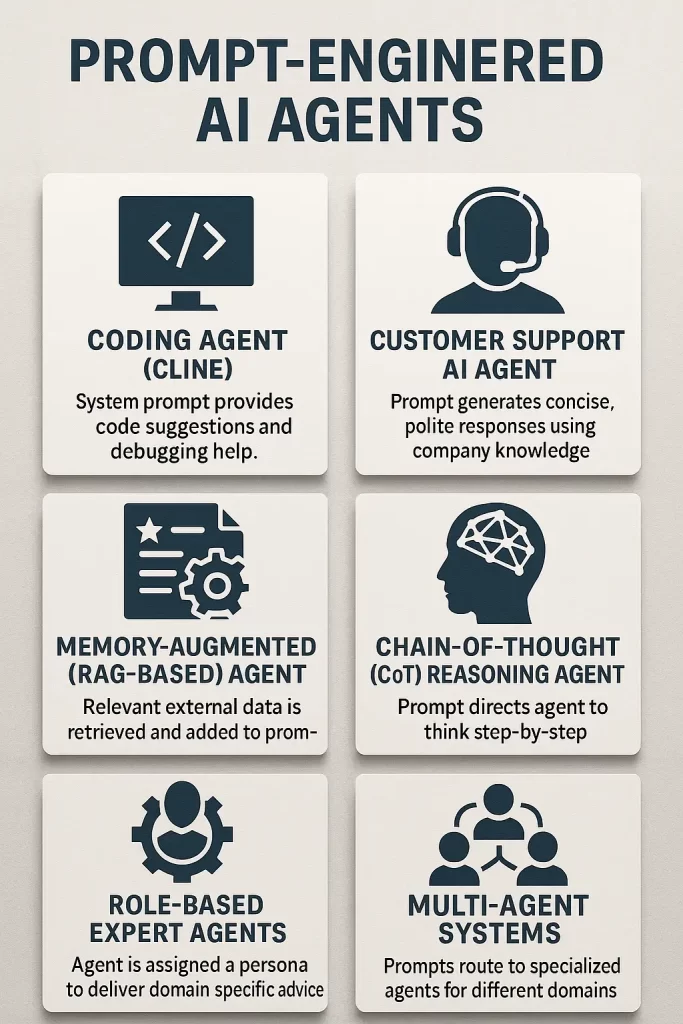

Prompt-gesteuerte KI-Agenten sind mittlerweile in vielen Bereichen im Einsatz – von Support bis Entwicklung. Ihre Anweisungen sind so formuliert, dass sie wirklich alltagstaugliche Hilfe leisten. Hier ein paar typische Beispiele, wie diese Agenten im Jahr 2025 genutzt werden:

Coding-Agent (Cline)

Nehmen wir Cline – ein beliebter Coding-Helfer, der direkt in viele Entwicklungsumgebungen integriert ist. Seine Vorgaben sind so gestaltet, dass er genau weiß, wie er unterstützen soll: Mit Code-Vorschlägen, Bugfixes oder verständlichen Erklärungen. So bekommen Entwickler immer praxisnahe Unterstützung, statt umständlicher KI-Antworten.

Kundenservice-Agent

Auch im Kundenservice sind diese Agenten echte Helfer. Sie liefern kurze, freundliche und auf den Punkt gebrachte Antworten – und greifen dabei immer auf das Wissen der Firma zurück. Die Prompts geben oft das Antwortformat vor (zum Beispiel: „Antwort bitte im JSON-Format mit Quelle“), setzen eine maximale Wortanzahl oder schreiben einen bestimmten Tonfall vor. Oft bekommt der Agent auch Beispiel-Fragen und -Antworten mit, damit der Stil stimmt.

Gedächtnis-gestützter (RAG-)Agent

Manche Agenten sind speziell fürs Nachschlagen gemacht. Sie nutzen sogenannte Retrieval-Augmented Generation (RAG): Stell dir einen Rechercheassistenten vor, der sich blitzschnell aktuelle Infos aus externen Quellen holt, ins Gespräch einbaut und so immer relevante Antworten liefert. Perfekt für Recherche, Support oder dynamische FAQs.

Chain-of-Thought (CoT) Reasoning Agent

Geht’s um mehrschrittige oder komplizierte Aufgaben, kommen Agenten ins Spiel, die angewiesen werden, ihre Gedanken Schritt für Schritt zu erklären. Besonders praktisch bei Coding-Bots oder Analyse-Tools, weil so die Antworten logisch und nachvollziehbar werden.

Experten-Agenten mit festen Rollen

Manche Agenten bekommen von Anfang an eine bestimmte Rolle. Zum Beispiel als Cybersecurity-Experte, der Code prüft und Schwachstellen findet. Oder als Marketingstratege, der Kampagnenideen ausarbeitet. Das macht die Antworten noch gezielter und praxisnäher.

Multi-Agenten-Systeme

Die fortschrittlichsten Systeme kombinieren mehrere spezialisierte Agenten – jeder mit eigenem Prompt und Wissen. So wird jede Anfrage automatisch an den passenden Agenten weitergeleitet, egal ob IT-Support, Rezepte, Fitness oder etwas ganz anderes gefragt ist.

Salesforce Einstein AI

Die manuelle Lead-Qualifizierung verzögerte Verkaufszyklen um 15 Tage. Prompt-gesteuerte Agenten analysierten CRM-Daten, um Leads mit hoher Kaufabsicht zu priorisieren. Das Ergebnis: 30% höhere Konversionsraten und 20% kürzere Verkaufszyklen. Diese Optimierung zeigt das Potenzial von agentischen CRM-Systemen für moderne Vertriebsteams.

Zendesk Answer Bot

Mehr als 10.000 monatliche Support-Tickets überlasteten das Personal. NLP-Prompts, die mit Wissensdatenbanken integriert wurden, lösten Tier-1-Anfragen automatisch. Das Ergebnis: 50% schnellere Ticket-Bearbeitung und jährliche Einsparungen von 500.000 USD.

Salvation Army Copilot-Implementierung

Die Organisation erzielte einen 1.000% ROI durch prompt-optimierte KI-Assistenten für die Formulierung von Förderanträgen und das Spendermanagement. Dieses Beispiel unterstreicht, dass auch gemeinnützige Organisationen erheblich von KI-Agenten profitieren können.

Sicherheits- und ethische Überlegungen

Prompt-Injection-Schwachstellen

Bösartige Eingaben können KI-Agenten manipulieren, wie durch CVE-2024-5184 veranschaulicht, das E-Mail-Systeme gefährdete. Input-Bereinigung und adversariale Tests reduzieren die Erfolgsraten von Exploit-Versuchen um 89%. Organisationen müssen diese Sicherheitsmaßnahmen implementieren, um ihre KI-Systeme vor Manipulation zu schützen.

Bias-Minimierung

Diversitätsbewusste Prompts reduzierten geschlechtsspezifische Vorurteile in HR-Screening-Tools um 64%. IBMs watsonx Prompt Lab markiert voreingenommene Sprache in Echtzeit. Diese Fortschritte sind entscheidend, um faire und gerechte KI-Entscheidungssysteme zu gewährleisten.

Die besten Prompting-Tools für KI im Jahr 2025

Im Jahr 2025 gibt es eine Vielzahl an spezialisierten Tools, die das Arbeiten mit KI-Prompts deutlich vereinfachen. Die folgende Übersicht zeigt, welche Plattform für welchen Einsatzbereich besonders geeignet ist – von Teamarbeit über kreatives Arbeiten bis hin zur Automatisierung im Marketing. So findet jeder das passende Tool. In 3 Monaten wird diese Tabelle allerings schon veraltet sein….

| Tool | Am besten geeignet für | Wichtige Funktionen |

|---|---|---|

| Team-GPT | Zusammenarbeit im Team, Marketing, Vertrieb | Gemeinsames Prompt-Management, automatisierte Workflows, Prompt-Builder, Organisation nach Teams |

| Coefficient | KI-Inhalte in Tabellen (Spreadsheets) | Automatisierte Prompts in Google Sheets/Excel, Daten-Benachrichtigungen, Vorlagen |

| PromptPerfect | Optimierung von Prompts für verschiedene Modelle | Unterstützung mehrerer KI-Modelle, Echtzeit-Feinabstimmung, Browser-Erweiterung, Batch-Optimierung |

| HIX AI | Aufgabenspezifische Prompts, Mehrsprachigkeit | Vorlagen, KI-Vorschläge, Unterstützung mehrerer Modelle, mehrsprachige Prompts, übersichtliche Organisation |

| Taskade | Aufgabenmanagement & Integration von Prompts | Integrierter Prompt-Generator, anpassbare Vorlagen, projektbezogene Prompts, plattformübergreifend nutzbar |

| Promptitude.io | Verwaltung, Test & Rollout von Prompts | Zentrale Verwaltung, interaktive Generierung, automatisierte Bereitstellung |

| PromptVibes | Kontextsensitive Prompts für Recherche/SEO | Über 500 vorgefertigte Prompts, Integration von Kontext, mehrsprachig, plattformübergreifend |

| PromptLayer | Analyse komplexer Workflows | Versionierung von Prompts, A/B-Tests, Teamfunktionen |

| AI Parabellum | Kreative Prompts (Text, Bild, Video) | Individuelle Anpassung der Prompts, vielseitig einsetzbar |

Markttrends und Karrieremöglichkeiten

Branchenwachstum

Nordamerika dominiert mit einem Marktanteil von 35,8% (136,5 Millionen USD im Jahr 2024), angetrieben von Technologiezentren wie dem Silicon Valley. Die Investitionen in Prompt Engineering im Gesundheitswesen werden bis 2026 1,2 Milliarden USD erreichen, mit Fokus auf diagnostischer Genauigkeit.

Gehälter und Nachfrage

Einstiegsgehälter liegen bei 85.000–95.000 USD jährlich und steigen auf bis zu 175.000 USD für leitende Positionen. Python/TensorFlow-Expertise erhöht das Grundgehalt um 15%, während NLP-Zertifizierungen Gehaltsvorteile von 20% bieten. Die steigende Nachfrage nach Prompt-Engineering-Fachwissen macht diesen Bereich zu einem attraktiven Karriereweg.

Bildungsressourcen und Zertifizierungsprogramme

Für Fachleute, die ihre Fähigkeiten im Prompt Engineering verbessern möchten, stehen mehrere hochwertige Ressourcen zur Verfügung:

IBM’s Generative AI: Prompt Engineering Basics (Coursera)

Dieser siebenstündige Kurs behandelt Zero-Shot-Prompting und Chain-of-Thought. Er bietet eine solide Grundlage für Einsteiger und ist besonders geeignet für Entwickler, die ihre ersten Schritte im Bereich KI-Agenten machen.

Learn Prompting Advanced Course

Dieser Kurs lehrt ReAct und RAG-Workflows für 21 USD pro Monat. Er ist ideal für Fortgeschrittene, die tiefer in komplexe Prompt-Engineering-Techniken eintauchen möchten.

Certiprof PEFPC

Diese Zertifizierung konzentriert sich auf Enterprise-Prompt-Design und wurde seit 2024 von mehr als 10.000 Fachleuten angenommen. Sie ist besonders wertvoll für Berufstätige, die ihre Prompt-Engineering-Fähigkeiten formal nachweisen möchten.

Zukünftige Entwicklungen im KI-Agenten Prompt Engineering

Multimodale Architekturen

Cross-modale Angriffe nutzen Bild-Text-Interaktionen aus, was neuartige Erkennungsrahmen erfordert. GPT-4o’s Vision-Language-Fusion verbessert die Genauigkeit bei industriellen Inspektionen um 28%. Diese multimodalen Fähigkeiten eröffnen neue Anwendungsbereiche für KI-Agenten.

Benchmark-Tools

PromptEval bewertet über 100 Prompt-Varianten pro Aufgabe und identifiziert leistungsstarke Vorlagen mit 90% Zuverlässigkeit. Der neue MMLU-Pro-Benchmark zeigt, dass GPT-4o nur 72,6% Genauigkeit erreicht, was auf erhebliches Verbesserungspotenzial hindeutet.

FAQ

Was ist der Unterschied zwischen Chain-of-Thought und ReAct Prompting?

Chain-of-Thought fokussiert sich auf die Anleitung des KI-Modells durch logische Denkschritte, während ReAct dies mit der Fähigkeit kombiniert, externe Informationen abzurufen und zu verarbeiten. CoT verbessert hauptsächlich Reasoning-Aufgaben, während ReAct besonders effektiv ist, wenn aktuelle oder spezifische Daten für die Entscheidungsfindung benötigt werden.

Wie kann ich Prompt-Injection-Angriffe auf meine KI-Agenten verhindern?

Implementieren Sie strenge Eingabevalidierung, verwenden Sie Sandboxing-Techniken und führen Sie regelmäßige adversariale Tests durch. Moderne Sicherheitspraktiken beinhalten auch die Einrichtung von Rollen und Berechtigungen für KI-Agenten sowie die kontinuierliche Überwachung von Interaktionsmustern, um ungewöhnliches Verhalten zu erkennen.

Welche Fähigkeiten brauche ich, um Prompt Engineer zu werden?

Grundlegende Kenntnisse in Programmierung (besonders Python), Verständnis von NLP-Konzepten und Erfahrung mit LLMs sind essenziell. Ebenso wichtig sind analytisches Denken, präzise Kommunikationsfähigkeiten und ein Verständnis für die Anwendungsdomäne, in der die KI-Agenten eingesetzt werden sollen. Spezifische Zertifizierungen können Ihre Bewerbung zusätzlich stärken.

Wie kann RAG die Leistung meiner KI-Agenten verbessern?

RAG verbindet die Generierungsfähigkeiten von LLMs mit gezieltem Informationsabruf aus vertrauenswürdigen Quellen. Dies reduziert Halluzinationen erheblich, verbessert die Faktengenauigkeit und ermöglicht kontextbezogene Antworten basierend auf Ihren Unternehmensdaten. Besonders wertvoll ist RAG für Anwendungen, die domänenspezifisches Wissen erfordern.

Quellen

- TechTarget: What is Prompt Engineering?

- Cobus Greyling: AI Agent Prompt Engineering

- PromptHub: 10 Best Practices for Prompt Engineering

- arXiv: Efficient Multi-Prompt Evaluation of LLMs

- Intellectyx: AI Agent Case Studies

- USAII: Top 10 AI Prompt Engineering Tools

- Market.us: Prompt Engineering Market Report

- K2view: RAG Prompt Engineering

- LearnPrompting: Prompt Engineering Courses